自由能原理:构建超级人工智能的一条可能路径

自人工智能概念提出以来,通用人工智能(AGI)就是工程界孜孜以求的目标。人工智能当前的发展如火如荼,出现了各种处理特定任务的专家系统[1],大语言模型、深度学习技术似乎为我们带来通用人工智能的曙光。然而,这些系统仍然只是执行狭义任务或一组相关的任务,不符合“通用”的标准。实际上,“狭义智能永远不能堆砌出通用人工智能。通用人工智能的实现不在于单个能力的数量,而在于这些能力的整合”[2]。

一些哲学家认为,通用人工智能本质上是通用人工生命,因为智能必须建立在生命的基础之上,应通过模拟思维过程来实现。这引发了一个问题:智能是否必须以生物体为基础,自然智能又能给我们带来怎样的启发?

卡尔·弗里斯顿(Karl Friston)等人在《基于第一性原理设计智能生态系统》(Designing ecosystems of intelligence from first principles)一文中,展望了下一个十年(及以后)人工智能领域的研究和发展愿景。文章指出,人工智能要超越对大脑的模仿,取法于自然,探究智能如何在生物体乃至一般物理系统中表现出来。文章勾勒出一种构建超级人工智能的可能路径:通过主动推理[3],以及基于视角采纳(perspective-taking)和共享叙事(shared narratives)来构建集体智能(collective intelligence)。最后,文章还探讨了人工智能的发展阶段及相关的伦理问题。

论文地址:https://journals.sagepub.com/doi/10.1177/26339137231222481

想要说明人工智能如何可能,不可避免地要说明什么是“智能”。然而,智能本身没有明晰的定义。当我们提及智能时,思想、理性、认知、意识、逻辑、情感等概念会跃入脑海。尽管很难给出单一的、判决性的定义,人们却就智能具有怎样的一般性特征达成了共识——智能是一个连续体,在不同尺度(个体智能、集体智能)有不同的表现形式和维度(如情感、社交、艺术等)。

尽管具有如上共识,但在过去许多年中,人类智能仍被视为衡量所有智能的金标准。神经科学家杰弗里·杰斐逊(Geoffrey Jefferson)写道,如果一台机器是因为“感受到”情感或思想,而非仅仅出于符号的组合,写出了一首十四行诗,它为写出这首诗感到快乐,那么这台机器就可以被认为是具有智能的。与此类似,一些哲学家认为,若要称得上真正的智能,人工智能需要具有意识或自我意识,而意识的一个本质特征是“像是什么”的现象特征。因此,人工智能若想真正的具有智能,需要具有主观体验。这种想法显然带有一种生物中心主义、乃至人类中心主义的色彩。

在人工智能设计中,自然系统及其经过演化精炼的设计始终是模型的灵感来源。其中,神经科学的贡献尤为显著。从早期的McCulloch-Pitts神经元模型,到联结主义和深度学习的并行分布网络,再到当下机器学习对“神经-人工智能”研究范式的呼声。然而弗里斯顿等人指出,人工智能设计不应当将目光仅仅局限在大脑中,应当拥抱各式各样的自然智能。

弗里斯顿等人认为,相较于通过描述和类比自然智能的方式设计人工智能,挖掘自然智能的底层原理并尝试将之与生物系统分离,更有可能通向通用人工智能。但问题在于智能的本质是什么呢?

探索智能的底层原理在上世纪40年代的控制论(cybernetics)中已初露端倪,诺伯特·维纳(Norbert Wiener)将控制论定义为“关于在动物和机器中控制和通信的研究”。当时控制论的研究中心是生命的自组织现象,其中“反馈”与“双向循环”扮演着重要角色。

阿什比(W. R. Ashby)提出的必要多变性定理(Law of Requisite Variety)与良好调节定理(good regulator theorem)很好地解释了个体与环境之间的双向循环:结构上的平行与过程中的互动 [4]。其中,必要多变性定理提出,为了有效应对环境的变化,个体内部的变化可能性应当至少与环境变化的可能性一样丰富。这样,个体才能拥有足够的适应性资源来应对外部的挑战。而良好调节定理则表明,为了维持系统的稳定状态,个体需要能够减小外部环境变化对自身的影响,这通常通过对环境进行有效的建模和预测来实现。

阿什比提出的两个定理捕捉了个体通过信息交换以实现自我维持的特质,在自我维持的过程中,智能表现为通过建模对感知和行动进行预测。主动推理发展了这一想法,并容纳了多尺度智能的可能性。

主动推理(active inference)是一个将智能理解为适应性行为的物理学公式化方法。它描述了智能体如何通过其生成模型(generative model)积累关于可感知世界的证据,这一过程被称为“自我证实”(self-evidencing)。

▪ 自我证实——智能自我维持的努力

主动推理表明,智能并不局限于生物体,而是与物体的个体性密切相关。物理个体的个体性依赖于稀疏的因果网络(sparse causal networks) [5],是一个既开放也封闭的系统。稀疏网络决定了哪些信息能够通过,哪些会被阻拦,从而维持了个体的开放性和有界性。

在一个不断变化的世界中,系统的有界性通过可预测和可控的边界条件来实现,由此形成一个既与外界交互又能保持相对稳定的生成模型。生物体与环境进行信息交换是为了自我维持,同样的,智能体也有自我维持的功能,Jakob Hohwy将此称作自我证实。这一能力嵌于(embedded in)感觉世界的生成模型中,以收集有利于模型的证据。

自由能原理与贝叶斯力学是主动推理的两大支柱。智能体通过最小化自由能来维持其对世界的模型。这个过程中,自由能被理解为复杂性与准确性之间的差值。缩小自由能就意味着模型在感知和学习过程中最小化复杂性的同时最大化准确性。自我证实的过程不仅涉及根据当前感觉输入和以往信念状态来推断环境状态,还包括通过行动改变感觉输入,使模型不仅寻找信息,更是根据偏好寻找信息,展现出好奇心和创新能力。好奇心,作为解决不确定性的驱动力,是智能系统的基本特征。

智能体所具有的生成模型是其个体性的标识。这种个体性通过自我监督和自我证实的方式得以维持。智能体以特定模型处理信息,意味着它们是通过一个特定的视角参与世界的。正如同他者的他异性界定了我的视角,稀疏因果网 络通过信息瓶颈界定了生成模型的视角。因此,稀疏因果网络揭示了智能体本质上是关系性的实体,它们通过与自己不同的事物来定义自己。从更大的范围来看,智能借助稀疏因果网络,分布在不同尺度的不同智能体中。

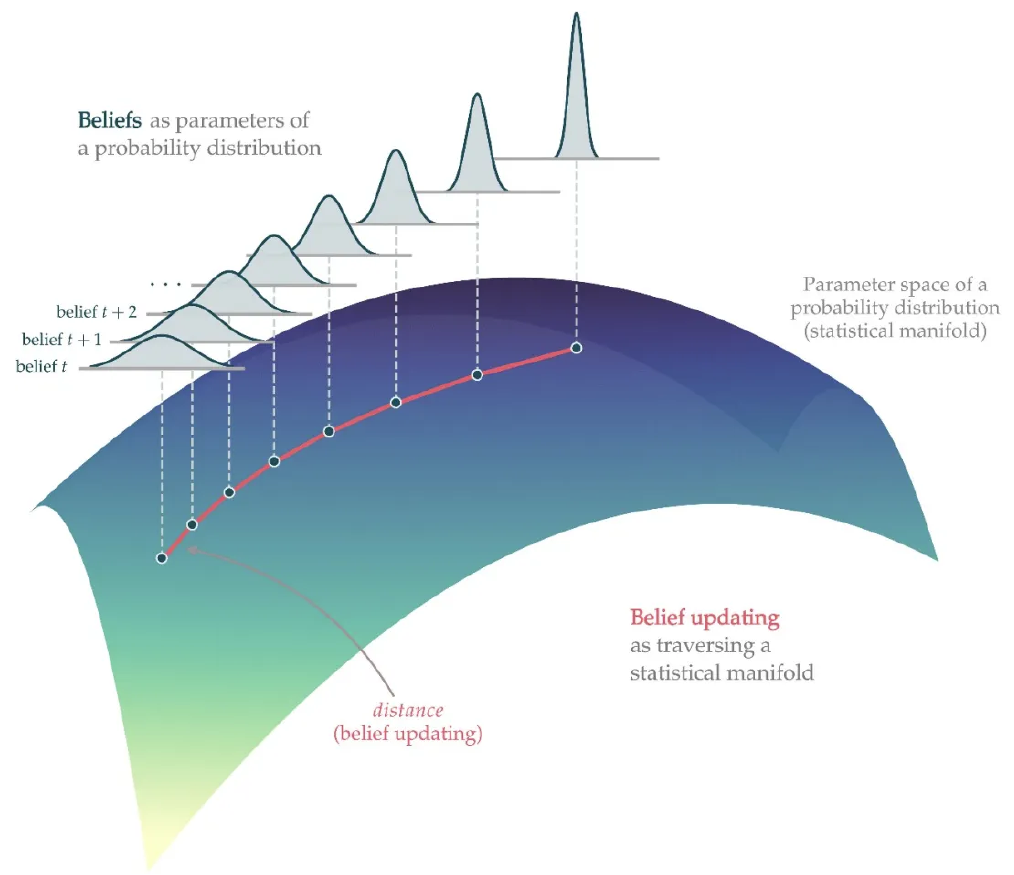

▪ 智能的动力学——信念更新

智能的动态特性体现在其更新信念的能力上,而贝叶斯力学提供了一种在信念空间中进行精确移动的理论框架。从数学层面来看,信念更新是在统计流形(statistical manifold)的抽象空间中完成的,空间中的每一个点对应着一个概率分布。这一抽象空间为人工智能系统物理或生物学层面的消息传递施加约束。它要求消息传递中的消息必须是关于概率分布的充分统计量或参数。这样的消息传递过程需要包含对不确定性的度量,即从分布中得到的任何变量需要与一个置信度相关联,即精度或逆方差。因此,按照上述原则设计的人工智能能够衡量不确定性,并采取行动以减小不确定性[6]。

一个模型之所以具有目的性,与其能够处理不确定性的能力密切相关。只有当模型结构中纳入了不确定性(即可能性),它才能准确地表征目标并作出准确的预测。实际上,可能性策略是学习的规范性理论。

这与强化学习所追求的理想化策略形成鲜明对比。强化学习开始于一系列随机操作,通过与环境的交互,系统在试错中进行学习,以最大化其回报,最终实现预设目标。在学习过程中,尽管强化学习系统也会遇到不确定性,但这种不确定性不会显性地反映在系统的结构或参数上。这导致这类智能系统无法“衡量”不确定性,也就无法为了特定的目标(偏好)选择行动,这与主动推理中的“自我证实”策略大相径庭。

从理论层面来看,可能性策略是设计智能系统的首选策略,但在实际操作过程中,这种策略可能会引入一些计算上的难题,特别是在必须对模型中的无关变量进行边缘化(marginalization)处理以获得对特定变量的准确“信念”的情况下。这与那些以优化(optimization)参数为核心的人工智能系统不同。当前最先进的人工智能系统被设计为具有普遍目标的理想化机器,它们只能解决特定领域的问题。然而,根据主动推理原则,理想化数据并不是智能的首要任务。

主动推理策略将复杂性与准确性置于同等重要的位置,通过在数量和维度上精简数据实现最小复杂化,并以最简约的、粗粒度的方式解释数据。通过这种方式,可以形成对世界的更简单、维度更低的表征,使得系统能够更容易地进行预测和解释。在这个过程中,允许足够的复杂性(即不确定性)来解释信息熵,就能在客观上满足阿什比所提出的必要多变性原理。

此外,由于复杂性会产生热力消耗(按照兰道尔定理),最小化复杂性有利于能量的高效利用。毫无疑问,最小化复杂性是从大数据迈向“智能数据”(smart data)的关键一步,它为发展通向通用的、更加稳健的人工智能的提供了路径。

最后,主动推理形式化地描述了自然智能多尺度的特征,并且允许分离的时间尺度,这为设计多尺度人工智能提供了基础。

智能不仅是多尺度的,更显示出强烈的个体性,即每个智能体都拥有独特的世界观和视角。这催生了一个问题:具备不同视角的智能体如何和谐共存?于是,构建一个良性的智能生态系统的概念应运而生。一个良性的生态系统需要参与其中的智能体有可交流的语言,在互动中产生共享叙事,并且具有视角采纳的能力。

▪ 巴别塔的启示

语言对于智能的重要性无须赘述。巴别塔的故事以隐喻的方式揭示了语言的重要性。《圣经·创世纪》中写道:最初,全世界只有一种语言,人们想建造通向天堂的巴别塔,上帝由此担心“以后他们所想做的,就没有不成功的了”。于是“混乱他们的语言,使他们彼此语言不通”。巴别塔的建造由于公共语言的消失毁于一旦,人们只能分散在各处,使用着只有局部范围可以理解的方言。巴别塔的故事是隐喻性的,却揭示出可交流的语言的重要性。

赛斯利亚·海耶斯(Cecilia M.Heyes)认为,智能与语言几乎是共同演化而来的,智能与语言互为脚手架,都是在社交互动中发展起来的。从演化的角度来看,语言的功能是促进相互交流和理解,从而推动更大尺度上的合作。从认识论的角度来看,语言的指称功能使得个体超越自我的藩篱,把握世界的关键。

▪ 视角采纳与共享叙事

语言与一种独特的信息更新方式紧密相联。设想如下两个情境,一是你和一头大象被关在一个漆黑的屋子里,二是你与你的五个朋友以及一头大象被关在漆黑的屋子里。在第一种情境中,你借助不断的摸索来更新你对所处环境的信念,减少对当前情境的不确定性,直至形成一个明确的认识——我与一头大象待在同一个房间;在后一种情境中,你与同伴沟通,很快就知道房间里有一头大象,就像盲人摸象一样,你们每个人都摸到了一部分并相互汇报分享给彼此。

诚然,在两个情境中,信念更新的过程是类似的。然而,前者仅是个人积累证据以更新后验信念;而后者却是基于有着共同语言和信念的共享生成模型,你们通过比较信念之间的相似性、推断共处的环境得出结论。这一共享的生成模型,极大地增强了对世界的可预测性,共享成为了相互理解的桥梁,构建了一个共同的信念空间。

共同的信念空间根植于智能体对视角的采纳以及叙事的共享之中。视角的采纳和叙事的共享构成了社会认知的核心,近来更在生成式人工智能的研究中受到了特别的关注。生成式神经网络有能力对其所接触的图片、音乐等进行再创造,这是人工智能与自然智能的动态交互。然而,真正拥有智能的生成式人工智能,其应对人类世界充满了无限的好奇与探索。

▪ 信念传播(belief propagation)与沟通协议

当前的人工智能是否能够基于可沟通的语言共享信息?答案是否定的。当前人工智能的通用语言是向量(vector),向量空间嵌于信息输入空间(文本或情境),通过已有的词典对文本或情境进行转化。这类似于不同语言间的翻译,但向量本身无法直接转化为更高阶的语言形式。

弗里斯顿等人提出了一个对共享叙事的设想,即类似于上文提到的与朋友一起摸象,通过因子图上的消息传递(message passing),实现一个共享的智能生态系统。每一个生成模型都对应一个因子图(factor graph)。因子图规定了具体的消息传递和隐性的计算建模。其节点对应于贝叶斯信念或概率分布的因素。例如,可以将关于对象的潜在状态的信念分解为“是什么”和“在哪里”。这些信念共同指定了外部空间中的一个独特对象;值得注意的是,知道某物是什么和知道它在哪里大体上是独立的。因子图的边对应于支持信念更新的因子之间传递的消息。

此外,因子图在每一个节点上又可划分为许多小的子图,即亚因子图。亚因子图具有来自内部的信息,也能通过与其他亚因子图沟通获得外部信息。原则上,这种建模意味着每一个亚因子图(或智能体)能够看到其他可观察的亚因子图。

因子图的设计理念,是以人类沟通中的粗粒度生成模型为蓝本,旨在追求复杂性与准确性之间的平衡。它可以通过尽可能简化的模型复杂度,以实现仅使用与维持对观察的准确描述所需的粒度。同时,这种粗粒度的生成模型推动智能系统设计向符号化、标识化、布尔逻辑及溯因推理的方向发展。也由于数据可以还原分子在特定层级的可能性分布,这使得模型能够灵活地更换文本,互相交换信息。

神经生物学指出,大脑是一个层级结构,大脑中的高阶因素会利用注意力机制筛选低阶信息。全局因子图要想具有这样的层级结构,就需要新的消息传递协议。这一协议能够在离散信念空间图上实例化变分消息传递。这些消息必须包含足够的统计向量,并确定相关的共享因子。此外,它们还必须包含关于其来源的信息,如同大脑中的神经元集群从大脑的其他部分接收包含着空间地址的信息输入。

简而言之,实现分布式的、涌现的共享智能的第一步是构建下一代建模和消息传递协议,其中包括不可还原的空间寻址系统,与之适应的向量,以及基于向量的人类知识的共享表征。

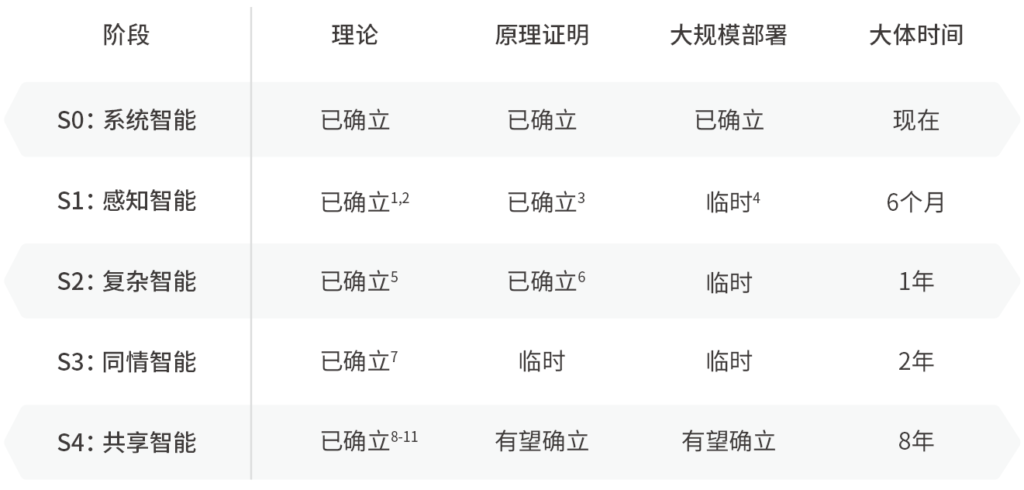

文章的最后,弗里斯顿等人提出基于主动推理的人工智能发展阶段:包括从现阶段的系统智能到具有偏好和视角的感知智能,最后到达更高级的共享智能。

▪ S0:系统智能

现阶段的系统智能的核心特征将感觉输入与行动输出进行系统性匹配,从而优化系统所定义的价值函数,深度学习和贝叶斯强化学习是典型案例。

▪ S1:感知智能

感知智能是下一阶段的发展目标。它是指能够对感觉信息作出回应,并通过推理行动的原因最大化期待的信息和价值的获取。期待和价值意味着模型具有偏好。

▪ S2:复杂智能

相较于感知智能,复杂智能不仅可以预测行动的结构,而且可以预测行动带来的知识状态,进一步形成关于世界的表征。这一阶段的智能运用模态逻辑、量子计算和范畴论进行公式化表述,这符合通用人工智能的要求。

▪ S3:同情智能

同情智能(Sympathetic Intelligence)可以辨别其他智能体的本质与倾向,也能识别自己的倾向性状态,这意味着共情智能具有心智理论(Theory of Mind),不仅能够区分自己与其他智能体,而且能够辨识自己和其他智能体的意图,具有视角采纳、共享叙事的能力。

▪ S4:共享(或超级)智能

共享智能以同情智能之间的互动为基础,这对应于通常所说的超级人工智能。不同之处在于,超级人工智能的设想以整合的个体为基础,而共享智能是一种分布式的集体智能,从智能的超空间网络涌现出来。

尽管我们的讨论开始于昆虫、树木的分布式集体智能,但昆虫的智能并非建立智能生态网络的理想范型,因为这种集体智能是由可替代的点构成的。而智能生态系统需要在同情智能的基础上实现信念共享,智能的个体性必须被保留下来。这是一个相当符合直觉的想法。在人类社会中,知识是有价值的,而知识与个体的生命密切相关,每个存在者都因为视角的独特性而享有独一无二的生命体验。在智能的领域,每个智能都有与其自我维持相适应的生成模型,这些模型不可相互替代。

伦理问题归根到底是规范性问题,不会随着技术的发展而自动消失。人工智能联盟相关的伦理问题将在同情智能和共享智能的发展阶段变得更加显著。

设计者应当设法避免病态联盟,如取消视角多样性的联盟,或将捕猎者-猎物模式包含其中的联盟。此外,集体智能还可能将数据中包含的偏见转化为系统的偏见。模型的使用本身不会进行自我审查并消除偏见,反而会保留甚至扩大偏见。由于系统中的偏见实际上是社会偏见的延伸,因此,仅靠技术手段无法彻底矫正,还必须辅之以相应的社会政策、政府调节和伦理规范。

回望过去对通用人工智能(AGI)与超级人工智能(ASI)的探索,弗里斯顿等人为我们构建出一个截然不同的视角,通过主动推理原则,搭建自然与人造智能交织的生态系统。

正如主动推理揭示的,智能的本质是一种不断寻求证据以验证其对世界的理解的过程。在这一框架下,智能体通过信念传播或消息传递,在图或网络上实现自我证实。主动推理不仅解释了集体智能,更推动着下一代通用的、超空间建模和消息传递协议的发展。

未来,在这个基于相互理解和共享的信念空间中,我们面临的最大挑战也许不再是技术本身,而是如何理解和定义我们想要创造的世界。![]()

作者: 雷沐春

编辑: 范存源

来源: 天桥脑科学研究院“追问nextquestion”媒体

[1] 专家系统:专家系统(Expert System)是指具备特定领域的专家水平的知识与经验,可以根据这些数据利用计算机模型模拟人类专家的思维过程进行推理,解决特定领域的复杂问题的计算机软件系统。

[2] 通用人工智能的实现不在于单个能力的数量,而在于这些能力的整合:见M. Loukides and B. Lorica, “What Is Artificial Intelligence?”O’Reilly, June 20, 2016.

人工智能的发展通常被认为有三个主要阶段:狭义人工智能(Narrow AI)只能执行语音或图像识别等特定类型的任务;通用人工智能(Artificial General Intelligence, AGI)表现出人类所具有的灵活通用的智能,能够适应环境,学习理解新概念;超级人工智能(Artificial Super Intelligence, ASI)则更进一步表现出超越人类能力的智能。要如何实现通用甚至超级人工智能呢?

[3] 主动推理:主动推理(active inference)是Karl Friston在自由能原理的基础上做出的延伸,解释了智能体(无论是生物还是人工的)如何通过行为主动地探索世界,以减少预测误差。

[4] “结构上的平行”意味着个体的内部结构(比如说,其认知、生理或者信息处理系统)与环境中的结构相呼应。这种呼应使得个体能够高效地处理环境信息,对环境变化作出快速反应。而“过程中的互动”则强调了个体和环境之间通过行动、感知、反馈等连续的动态交互,实现信息的双向流动。

[5] 稀疏性:简单来说,稀疏性与密度(density)并肩而行,如果一组数据是有意义的,就会呈现出在部分区域聚集,部分区域分散的特征。稀疏性与密度共同定义了数据的意义,即表明数据之所是与所不是。

[6] 不确定性:通常有如下几个来源,首先是数据测量过程本身所包含的噪声;其次是数据中隐藏变量的模糊性(这幅图看起来是鸭子还是兔子?),还有模型运作中的噪音(兔子看起来应该是什么样子的?)。战胜这些不确定性对于学习来说至关重要。

参考文献

[1] Friston, K.J. A free energy principle for a particular physics. doi:10.48550/arXiv.1906.10184 (2019). (Friston, 2019).

[2] Ramstead, M.J.D. et al. On Bayesian Mechanics: A Physics of and by Beliefs. 10.48550/arXiv.2205.11543 (2023). (Ramstead et al., 2023).

[3] Parr, T., Pezzulo, G. & Friston, K.J. Active Inference: The Free Energy Principle in Mind, Brain, and Behavior. (MIT Press, 2022). doi:10.7551/mitpress/12441.001.0001. (Parr et al., 2022).

[4] Mazzaglia, P., Verbelen, T., Catal, O. & Dhoedt, B. The Free Energy Principle for Perception and Action: A Deep Learning Perspective. Entropy 24, 301, doi:10.3390/e24020301 (2022). (Mazzaglia et al., 2022).

[5] Da Costa, L. et al. Active inference on discrete state-spaces: A synthesis. Journal of Mathematical Psychology 99, 102447, doi:10.1016/j.jmp.2020.102447 (2020). (Da Costa et al., 2020).

[6] Friston, K.J., Parr, T. & de Vries, B. The graphical brain: Belief propagation and active inference. Network Neuroscience 1, 381-414, doi:10.1162/NETN_a_00018 (2017). (Friston et al., 2017).

[7] Friston, K.J. et al. Generative models, linguistic communication and active inference. Neuroscience and Biobehavioral Reviews 118, 42-64, doi:10.1016/j.neubiorev.2020.07.005 (2020). (Friston et al., 2020).

[8] Friston, K.J., Levin, M., Sengupta, B. & Pezzulo, G. Knowing one’s place: a free-energy approach to pattern regulation. Journal of the Royal Society Interface 12, doi:10.1098/rsif.2014.1383 (2015). (Friston et al., 2015).

[9] Albarracin, M., Demekas, D., Ramstead, M.J.D. & Heins, C. Epistemic Communities under Active Inference. Entropy 24, doi:10.3390/e24040476 (2022). (Albarracin et al., 2022).

[10] Kaufmann, R., Gupta, P., & Taylor, J. An Active Inference Model of Collective Intelligence. Entropy 23 (7), doi:10.3390/e23070830 (2021). (Kaufmann et al., 2021).

[11] Heins, C., Klein, B., Demekas, D., Aguilera, M., & Buckley, C. Spin Glass Systems as Collective Active Inference. International Workshop on Active Inference 2022, doi:10.1007/978-3-031-28719 (2022). (Heins et al., 2022).

[12] Bourrat, Pierrick ; Takacs, Peter ; Doulcier, Guilhem ; Nitschke, Matthew ; Black, Andrew ; Hammerschmidt, Katrin & Rainey, Paul, Individuality through ecology: Rethinking the evolution of complex life from an externalist perspective.

[13] Godfrey-Smith, Peter (2016). Individuality, subjectivity, and minimal cognition. Biology and Philosophy 31 (6):775-796.

[14] Slijepcevic, Predrag (2020). natural intelligence and anthropic reasoning. Biosemiotics 13 (tba):1-23.

[15] 陆俏颖,詹心怡.主体经验的认知演化进路初探:从个体性跃迁的视角[J].科学·经济·社会,2023,41(04):63-73.DOI:10.19946/j.issn.1006-2815.2023.04.006.