12月8日,欧盟立法机构就《人工智能法案》达成初步政治协议[1]。这意味着尽管法案细节仍会有调整,但规制框架已基本确立。似曾相识的节点不禁让人联想起 2015年12月,当时欧盟就GDPR(欧盟数据保护条例)文本达成一致,并在转年批准通过法案,就此开启GDPR时代。

AI时代,欧盟会继续演绎“布鲁塞尔效应”,复制下一个GDPR么?

“布鲁塞尔效应”的神话

“布鲁塞尔效应”最早由学者Anu Bradford[2]提出,是指:欧盟通过其单方面的市场规制能力,在无需他国家、国家机构协作的情况下,制定出全球市场遵循的规章制度。这种规则制定能力引领了全球商业环境的形成,导致许多全球商业重要方面的“欧洲化”。

在GDPR之前,“布鲁塞尔效应”在化学品安全标准、航空业碳排放等领域都有成功案例。在数字经济领域,人们熟知的GDPR,更是将“布鲁塞尔效应”发挥到极致:

(一)推动各国立法向GDPR靠拢。GDPR推动了全球个人信息保护法的立法浪潮,并成为许多国家制定立法的第一参考,包括巴西、印度、日本、韩国、南非、阿根廷和肯尼亚等等。尽管英国不再是欧盟成员国,但仍颁布了与 GDPR 范式相同的立法;美国一直未出台联邦层面的隐私立法,但受GDPR影响,美国第一科技大州——加州也出台了《加州消费者隐私法案》 (CCPA),被称之为美国小GDPR。中国2021年出台的《个人信息保护法》也随处可见GDPR的影子,甚至部分规范更加严苛[3];

(二)改造了跨国公司的数据合规体系。尽管仍有部分例外,全球跨国企业将GDPR作为主要的合规基准;

(三)在全球数据跨境流动中,各国争取纳入欧盟“白名单”,为本国企业建立稳定的数据跨境流动渠道。日本、韩国、印度等均积极申请欧盟的“白名单”认证。美国也一次次通过安全港(2000)、隐私盾(2016)、隐私框架(2023),与欧盟达成双边协议,以更加全面的保护承诺寻求欧盟的认可。

历史的车轮来到AI时代。在达成协议之后,欧盟议会发布称:欧盟 《AI ACT》 可以像 GDPR 一样,为其他司法管辖区的人工智能监管制定全球标准,在世界舞台上推广欧洲的技术监管方式。

欧盟《AI ACT》

依旧延续GDPR系统的基本风格

欧盟 《AI ACT》 是目前为止最为全面系统的人工智能法案。

尽管部分国家在AI的部分应用场景,如自动驾驶、人脸识别领域已出台相关法律规范;我国也在今年7月颁布《生成式人工智能服务管理暂行办法》规章,但以上规范只是侧重于AI在某一行业或领域内的应用,与当前AI技术应用对社会带来的广泛深入的影响相比,只是管中窥豹。

纵观欧盟《人工智能法》,从法规体系性来看,尚未有出其右者。简言之有三个方面:横向立法模式,全生态主体与多元化议题。

(一) 横向立法模式

如同GDPR一样,欧盟《人工智能法》采取了横向立法模式,即适用于所有投放于欧盟市场或者在欧盟可使用的AI 系统,可以覆盖金融、医疗、内容、教育、能源、运输、司法等各个行业领域;这显然与美国更加偏好的区分行业领域的垂直立法模式有着显著区别。

(二)全生态主体

其所确立的法律主体,覆盖了AI产业全生态。

其中,主要市场主体包括:

1.提供者(Providers):是指开发人工智能系统,并以期以自己的名义投放市场或使用的实体(无论是付费还是免费)。它们负责确保其系统符合法案的要求,尤其是在安全性、透明度和尊重基本权利方面。例如:OpenAI,Microsoft,Google,Meta等模型开发者;

2.部署者(Deployer):是指在其授权下,将人工智能系统实际应用于特定环境或场景中的实体。例如政府部门、金融、医疗、教育机构等等,他们将人工智能技术整合到产品、服务或运营流程中。部署者要确保他们使用的人工智能系统符合法定的风险管理和合规要求,对于被分类为高风险的AI系统,部署者还需要遵循更加严格的规定。

3.进口商和分销商(Importer ,Distributor):是指将欧盟之外的人工智能系统投放至欧盟市场,以及在供应链中的市场服务主体。例如:从非欧盟国家进口含有AI技术的电子产品,如智能家居设备、智能穿戴设备等。

《人工智能法》几乎360度全景覆盖了AI现有产业生态中各类主体,并为其量身匹配了不同的法定义务。同一个市场主体,在不同场景下,也可以兼具不同的法律身份。例如openAI作为大模型的开发者,是人工智能系统的提供者,同时它也是ChatGPT应用的部署者。

监管框架中的法定主体包括:

(1)各成员国主管机构(National Supervisory Authorities):负责在本国内适用和实施AI ACT;

(2)欧盟人工智能办公室( AI Office,在欧盟委员会下设)。是欧盟层面的监督协调机构,主要由成员国主管机构派出的代表构成。类似当前GDPR实施机制中,欧盟EDPB(数据保护委员会)与各成员国监管机构的关系。

(3)欧盟及其成员国现有的其他监管机构。如欧盟央行、数据保护监管机构(EDPB),各成员国中的各行业、各领域涉及人工智能系统的监管机构,如交通、医疗、教育等部门,《AI ACT》有专门篇幅涉及以上机构及其现有法规的协调。

(三)多元化议题

基于风险的规制思路,使得欧盟《AI ACT》几乎囊括了目前可见的,AI对于人类及社会发展带来的所有风险议题,包括:

1.个人基本权利:包括健康与生命安全、公平不被歧视,操纵、隐私保护等等;

2.民主法治原则:例如:关于在公共场合中应用远程适时人脸识别是否应当被完全禁止的议题,主要是从对民主法治原则出发的考虑;

3.内容治理:包括对生成内容的合法性的基本要求,其中版权问题交由欧盟版权法体系安排;

4.产品安全:AI系统被嵌入产品服务中产生的安全问题,除了法案作出一些基本要求(技术文档、质量管理体系、一致性评估等),还涉及与现有的产品安全立法的协调,法案专门以附件形式列出了需要协调的立法清单,包括了民用航空、机动车、海洋设备、医疗设备、铁路系统、玩具、电梯等等;

5.能源效率与环境保护:欧盟对环保话题的高度关注,在人工智能法中亦有体现。法案指出:为了更好地理解人工智能系统对环境的影响,提供者起草的技术文件应包括人工智能系统的能源消耗信息,包括开发期间的消耗和使用期间的预期消耗。

6.就业与劳动保护等多个议题。

当然以上问题并非均由《人工智能法》一部法律来回应,因此,法案专门以附件形式列出了需要与之协调的现有法律清单,这更加凸显了《AI法案》作为综合性立法的特征。

但能否复制GDPR模式,显然不能仅仅依靠大而全的法律体系,以及已经备受争议的域外效力,而是能否做到俯身探究技术原理与产业生态,在把握发展规律的前提下,开出治理良方。

能否引领全球AI治理,取决于

《AI ACT》是否足够开放包容

与GDPR时代相比,当前围绕AI的国际治理存在显著的差异点:

(一)技术飞越及其带来的挑战,已经从量变转变为质变

从1995欧盟数据保护指令到2016 GDPR的二十年间,技术产业从桌面互联网发展至移动互联网,对于个人信息的收集处理的范围、频度、深度虽然呈现指数级的增长,但在本质上,其并没有颠覆数据处理的基本范式,只是更加规模化。因此作为95指令的增强版本,GDPR 引入了更全面的用户权利,更严苛的合规标准,更有威慑力的处罚,满足了来自用户的权利主张和监管的干预需求,也成就了GDPR自身。

但在AI 时代,特别是过去两年所经历的基于LLM大模型的AI技术突破式发展,人类从未如此接近通用人工智能(AGI) 。通过AGI与各场景的结合,人类即将开启人机协作与技术创新的新范式,进而对经济和社会演化带来跃迁式影响。每个个体,每个行业都将全面迎接人工智能技术革命,改造原有的认知与行动方式,挑战前所未有。

(二)对此,包括欧盟在内的全球各国并没有相应的规制积累

最典型的是,在2021年4月,欧委会提出人工智能法草案时,基础模型概念甚至尚未浮现。直至2023年 3月GPT 4横空出世,欧盟加速审议《AI ACT》,才就是否引入“基础模型”展开辩论,这一议题也随即成为AI法案中最为焦灼的议题之一。

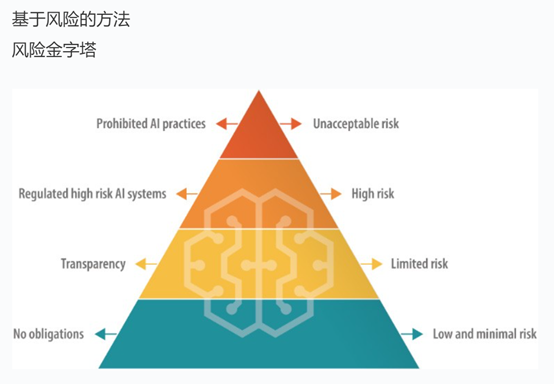

基础模型对《人工智能法》“基于风险”的规制框架提出了直接挑战。参照其价值观体系,欧盟将AI系统按照风险等级区分为四类:不可接受之风险(禁止类),高风险(配置法定义务),有限风险(配置轻度透明性义务)。低风险(豁免适用)。而基础模型的特点是:其AI能力具有通用性,可以被应用在任何领域,那么模型开发者与模型部署者究竟如何划分责任?

2023年10月,欧盟立法三方就基础模型的监管达成初步一致,但11月来,法国、德国、意大利等至少五个成员国开始提出不应对基础模型施加任何监管的要求,以期对本国正处于发展之中的AI公司(如法国 Mistral ,德国 Aleph Alpha)予以保护。12月会谈达成一致的AI法案中最终采取了差异化规制方式,对基础模型进行了分层,引入了具有高影响力的通用人工智能模型概念。目前虽尚未看到最终法案文本细节,但可以预测,基于基础模型的复杂性,法案应当保留了相当大的弹性空间。

(三)全球层面的规制协调更为迫切

目前,AI技术仅在少数国家出现了跨越式突破发展,AI治理的国际协作显得尤为重要。正如OpenAI CEO Sam Altman 所呼吁:AI应像“原子能事务”一样,需要在联合国设立协调机构。

此次欧盟AI立法也关注到了与国际规则的协调一致问题,以确保法律的协调性与广泛认可。为此 AI ACT专门修改了“人工智能”定义,以与OECD保持一致。“人工智能”:是指基于机器的系统,它被设计为以不同程度的自主性运行,并且可以为了明确或隐含的目标,产生诸如预测、建议或决定等影响物理或虚拟环境的产出。该定义抓住了人工智能”自主性”的关键特征,以便将其与更简单的软件系统或编程方法区分开来。在欧盟推进《AI ACT》的同时,欧盟与美国也通过美欧贸易和技术委员会,来推进AI治理的相互协作。

(四)欧盟能否在GDPR中汲取经验教训,是《AI ACT》成功与否的关键

在以上具有明显差异的历史背景下,欧盟《AI ACT》能否延续欧盟影响力的关键性因素是其是否足够开放包容,特别是汲取GDPR的经验教训,为技术创新和产业发展留有足够空间。

众所周知,欧盟在维护人类基本权利方面,是不遗余力的,但这也导致在另一方面,欧盟所设置的规则过于理想化,与技术产业脱节严重。有越来越多的现象和实证数据显示,GDPR实施对于欧盟数字经济竞争力带来了显著的负面效应。美国经济学研究机构NBER发布了权威研究报告数据表明,仅GDPR生效的半年间,欧盟科技领域的中小企业在融资方面陷入下滑困境[4];而在同时,GDPR严苛的合规要求巩固了大企业的市场地位,换言之,所谓“布鲁塞尔效应”一定程度上是以欧盟市场作为了换取代价,这是欧盟立法者在打造GDPR之初时未曾预料到的。

审视欧盟《AI ACT》文本,可以看到欧盟立法者对规制的负面效应有所关注,试图给技术创新更多的开放空间,例如:

1.明确对AI的科学研究、研发予以豁免。

2.为支持AI系统的发展,特别是出于减少AI负面偏差的目的,对处理敏感特殊数据的豁免。

以上两方面,在GDPR中都未曾有考虑。

3.基于风险的规制思路,本身也反映了一种包容态度。将规制指向了高风险AI ,而非所有AI。

4.明确引入监管沙盒。如企业遵循沙盒指导,将免于对条例违法行为的行政处罚。

5.作为审慎考虑的一部分,《AI ACT》延续了GDPR过渡期的做法,即在法案批准通过之后,仍旧给予2年时间才予以正式生效。也就是说,即使在最乐观的情况下,《AI ACT》最早也是在2026年生效。

6.在立法过程中,注重与技术产业界的沟通,并积极采纳建议。如在透明性方面,采纳了数据卡、模型卡等最佳实践范式。

值得一提的是:

7.在AI市场准入与安全管理中,欧盟继续遵循了单一市场的基本要求,用一致性评估(Conformity Assessment,CA)体系代替行政许可。

作为产品安全与准入管理体系,一致性评估在欧盟有着悠久的历史,也是欧盟内部市场的重要管理惯例。技术标准可以吸引更多的市场主体参与,避免行政机关的信息不对称。特别是在欧盟单一市场背景下,通过透明的技术标准体系在一定程度上有助于防止各成员国通过行政手段对符合技术标准体系的AI系统或产品施加不合理的市场准入限制。在大部分情形下,厂商可以通过自我评估,表明符合欧盟技术要求,这显著减轻了企业的合规负担。

但总体来看,欧盟《AI ACT》目前设置的合规义务,其繁文缛节仍受到广泛批评。高风险人工智能系统必须符合一系列要求:风险管理、数据治理、质量管理、基本权利影响评估,人工监督,售后市场监控系统等等。这些高规格的要求是否与当下的AI技术发展过于脱节,或者在AI发展初期就带来过于沉重的负担,尚需进行系统性的审视评估。

欧盟能否打破笼罩其上空20年之久——“产业落后,规制领先”的魔咒?

参考资料来源:

[1]https://www.consilium.europa.eu/en/press/press-releases/2023/12/09/artificial-intelligence-act-council-and-parliament-strike-a-deal-on-the-first-worldwide-rules-for-ai/

[2]Bradford, Anu (2012). “The Brussels Effect”. Northwestern University Law Review. Columbia Law and Economics Working Paper No. 533. 107 (1). SSRN 2770634

[3]王融,易泓清,腾讯研究院:中美欧个人信息保护法比较|附4万字解读报告,https://www.tisi.org/19493

[4]Jian Jia,Ginger Zhe Jin,Liad Wagman,THE SHORT-RUN EFFECTS OF GDPR ON TECHNOLOGY VENTURE INVESTMENT,NATIONAL BUREAU OF ECONOMIC RESEARCH,November 2018

本文作者:王融 腾讯研究院首席数据法律专家