|

豆瓣平台上有一个名叫“人机之恋”的小组,组内成员分享的大部分内容,都是一款聊天软件 Replika 的使用心得。 通过这款软件,用户可以与自己创造的“机器人”聊天,并与之建立亲密关系。 相当多的分享者形成了这样的共识: 至少在 Replika 中,人与程序的情感交互是可能的。 但持有类似观点的群体还相当小众。 “人机之恋”这个极具科幻色彩的词汇,尚停留在影视文学等作品中,离我们真实生活仍然遥远。 回归日常情境,我们与“机器”的关系,仅仅是停留在“对话”这一维度: 我们向 AI 助手发出指令,后者接受指令、解析并执行,然后给出反馈。 类似的交流模式,多见于智能家居、手机应用等场景。 随着人工智能技术不断发展,特别是语义识别等技术日渐成熟,与 AI 交流的相关问题开始被频繁探讨。 在这些声音中,非常有代表性的一种担忧是: 当我们已经习惯了以命令式的口吻与 AI 交流,并且能迅速得到回应,这种模式会不会在潜移默化中影响我们对“交流”的定义,并改变人与人之间的交流、沟通? 2017 年,苹果公司推出了一则 Siri 宣传广告,可以作为人类与人工智能助手对话的范例: “巨石”强森扮演的主人公,通过 Siri 处理生活中各种事务,包括查看日程、提醒事项、叫车等生活琐事,他全程没有操作手机屏幕,仅仅是发出如“Hey,siri,read my schedule! ”等指令。

“巨石”强森拍摄的广告片《事事在握》

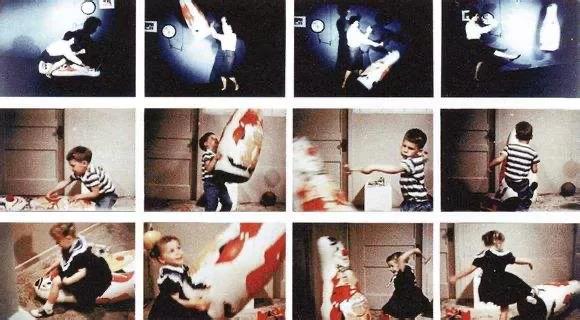

Siri 是最具代表性的人工智能助手,它在 2007 年面世,并在 2010年被苹果以 2 亿美金收购。 以 Siri 为代表的人工智能助手在智能家居控制、智能导航等领域的大规模应用,便利了日常生活。 人们可以通过说“小爱同学,打开客厅灯”控制室内照明,或者使用Google Home 或 Alexa 来设定厨房用品购物清单,为家人准备晚餐。 但现在人工智能助手还相对初级。 技术投入伊始通常会伴随追捧和质疑,比如前述的那个问题: 当 AI 深度介入我们生活的时候,我们是否会对命令式的话语交流方式习以为常? 当“Hey siri”似乎可以解决大部分问题的同时,类似担忧随之出现: 这种指令式语句是否会影响交流方式、尤其是改变儿童语言行为,养成“没有礼貌的下一代”? 问题在于,我们为什么会使用简单指令与AI交流呢? 这与效率有关,也与科学技术与生俱来的目的紧密相关。 在人类的认知基模中,科技发明就是为了拓展人类认识外部世界的途径,给人类带来利益,不断满足人类的各种需求。 作为一种技术类型,AI 的初衷和更新迭代路径也是要使机器变得越来越“聪明”,以便更好帮助用户解决问题。 就像我们使用扫把扫地之前,并不会向它征求意见。 因为在我们的潜意识中,它是没有感情的“工具”。 同样,面对人工智能助手,尽管它能与我们“交流”,但我们仍然清晰地意识到,这些对话是自动化程序生成的结果。 它们仍是工具,唯一不同的是它们能发出一些声响。 因此,不同于人与人之间的交流往往需解读话语的隐藏含义,智能语音识别技术更多是对直接的指令进行回应,即凸显 “工具性”。 著名语言哲学家维特根斯坦的“语言游戏”理论认为,人类语言作为传递情感信息的工具,以符号、文字、图案、音乐、语音、肢体动作与面部表情等为载体。 而用户与机器对话的过程并不关涉肢体动作、面部表情等体现情绪的“无声语言”。 因而,人类创造出代码语言与人工智能进行互动时,即使智能音箱、手机助手等能够对我们的情绪进行简单识别,究其本质依旧是工具使用,或者说是代码运转,具备程式单一性。 换句话说,人类与人工智能交流的过程并不产生情感等意义共享,此类语言交往和对话并不能形成完整的双向传播和交流链。 用户语音控制的本质是: 基于目的发出命令,与以往“点击屏幕”“按下开关”等指令动作没有区别,只不过语音控制解放了我们的双手,以语言命令的方式取而代之,这是目前最有效率的一种方式。 Synced 曾对 2017 年的人工智能失误进行了总结,其中十大“失败案例”中提到: LG 的 IoT AI 助手 Cloi 在拉斯维加斯国际消费电子展上首次亮相时,作为能够识别控制家用电器语音命令的人工智能,却迟迟未能回应 LG 市场营销主管的语言指令,该场面一度堪称典型“社死瞬间”。 类似的 AI 失灵问题不断提醒我们,所谓的人工智能很可能只是“人工智障”。 依靠代码运转的智能语音识别技术,目前还远不能取代人类复杂多样的语言交往实践,甚至可能带来诸多负面影响。 这并不是无根据的揣测或者危言耸听。 语言学的基本观点认为,语境、意义环境等都会影响交流和用语习惯,而美国语言学家本杰明·沃尔夫曾提出“沃尔夫假说”,意即不同语言结构差异会决定语言使用者对世界的感知和认知。 不难想象,伴随着指令性语言越来越多地进入日常生活,人们会逐渐模糊与机器交流以及与人交流的界限,从而将指令性用语习惯带到人际交往中,长此以往,也许将来“请”“谢谢”等交际常用词汇将濒临消失。 更重要的是,这一问题或将对成长中儿童的语言交流产生更显著的影响。 心理学研究普遍认为: 孩童自出生起即观察这个世界,在很长一段时间里通过模仿别人的行为 (表情、语言、行为、思维) 获得成长,他们的辨别能力相对较弱,无法作出判断、筛选和剔除,很可能全盘习得。 美国著名心理学家班杜拉就曾做过一个被称为“波波玩偶”的实验,在实验中儿童通过模仿“榜样”对玩偶施暴而习得暴力行为,因此,他认为儿童社会行为习得主要通过观察、模仿现实生活中重要人物的行为来完成。

光明网的一篇新闻报道也证实了这一点: 一位家长反映孩子看了动画片《熊出没》之后,学习影片中主人公的话语骂出“臭狗熊”等词汇。 媒体指出,央视热播的动画片《熊出没》曾在 10 多分钟的内容里,出现了 20 多次不文明语言。 据报道,在儿童影视剧的影响下,多地都曾出现过儿童仿效其中暴力场面的案例。 因而,《熊出没》等动画片后来被规定为适合 10-14 岁收看。 同样,美国电影分级制度的初衷也是由家长们组成的委员会负责,根据电影的主题、语言、暴力程度等对电影进行评价,帮助更多的父母们判断哪些电影适合特定年龄阶段的孩子们观看。 与担忧影视中的暴力语言对孩子产生的影响相比,和 AI 交流可能产生语言交流上的负面影响似乎远没有引起家长们的警觉,学术界也尚未有成熟的研究结论。 但这些负面影响仍然不容忽视。 当儿童长期与人工智能进行交流,在“模仿”的学习机制作用之下,难免会产生语言使用上的变化,越来越靠近如 AI 般的机械化交流。 指令性语言违背的是语言交流中的“礼貌原则”,即说话人在说话时往往都应当尽量多给别人一点方便,从而在交际中使双方感到受尊重,同时反过来获得对方对自己的好感。 与之相反,指令性话语交流方式的权力差异和不礼貌行为,将会在很大程度上造成交际失败,甚至使交流对象对你敬而远之。 可以想见,如果一个儿童与家长和朋友说话时满嘴都是“给我拿玩具”“帮我打开游戏机”; 偶遇陌生人问路时理所当然开口“hey,带我去这个地方”; 甚至请同事帮忙时说“你帮我做一下这个”,这样的命令语气,至少现在看来除了 AI,没有人会予以理睬。 当然,以上可能导致语言交流的负面变化并非无人察觉。 因为担忧与人工智能的交流方式会使用户,尤其是儿童说话变得“没有礼貌”,国内外许多科技公司对相关产品进行了优化。 比如,在2018年,亚马逊和谷歌相继在其智能助手中加入了鼓励礼貌用语的功能,例如当人们使用please时,助手会回应“Thanks for asking so nicely”以示嘉奖。 在实现 AI 与人更好的情感互动方面,以 AI 情绪研究为代表的技术正试图使机器与人的对话变得更加智能、处理更为复杂的人机交互。 这一领域的进展主要表现在两个方面: 一是加强 AI 对人类基本情绪类型的感知,通过识别说话人的言语、表情等完成; 二是加强 AI 对人类情绪的反应。 类似的改进自然能够使机器不再作为一个“工具人”,更能与用户在交流的过程中共情。 如微软所开发的第五代“小冰”,与前几代不同,它的功能并不仅限于简单的聊天回复,更能够具备自主的语言组织能力。 微软甚至让其冲破虚拟技术的束缚,为用户送上电话生日祝福。 小米公司的小爱同学5.0版本,也变得更聪明、主动,具备人文特征。 在这些努力之下,人工智能仿佛拥有了情感,也让用户不再将其视为一个语调冰冷的机器,而能感受到它所作出的情感回馈,有效避免了儿童陷入对命令式对话的模仿和习惯。 问题是,应对指令式交流进入语言交流的方式,仅仅通过机器作简单的情绪识别与回应还远远不够。 在传播学的基本观点中,人类的“交流”被赋予“意义共享”之意,只有人与人之间的交往才能产生情感与意义交换。 面对冰冷的机器,我们很难在语言交流中赋予如“礼貌”“爱”等情感。 因此,若想使人机交互更加接近人际传播的交流和分享,首先应正视两者在交往中存在的差异,进而从技术层面加强人工智能对对话信息量的处理和识别能力,使 AI 在交互中不断进行预测、保持与引导,同时提供人类理解算法交流的可能性和方法。 随着 AI 技术的不断演进,人与机器的语言交流方式更加多元,在面对新技术与其伴生的交流问题时,甚至会重新定义“交流”的意涵,拓展“ 意义共享”的面向。 更现实的影响可能是 ,与AI 交流将促使我们重思交流的边界,以及语言交往所具备的社会意义。